حرب رقائق الذكاء الاصطناعي

الذكاء الاصطناعي ينمو بسرعة هائلة. النماذج الكبيرة مثل شات جيبيتي تحتاج إلى قوة حوسبة قوية. الرقائق الخاصة هي العنصر الرئيسي الآن. بدونها، لا يمكن تدريب هذه النماذج بكفاءة. هذا يجعل المنافسة شديدة بين الشركات الكبرى

11/21/20251 دقيقة قراءة

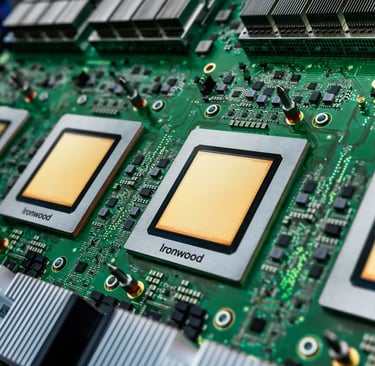

البطل الحالي: سيطرة NVIDIA وعمارة Hopper

NVIDIA تسيطر على سوق الذكاء الاصطناعي بنسبة كبيرة. تصل إلى 80% من السوق حسب التقارير. السبب الرئيسي هو CUDA، البرمجية التي تجعل كل شيء سهل. الرقائق الجديدة مثل H100 و H200 تستخدم عمارة Hopper. هذه الرقائق سريعة جداً في التدريب.

الغوص في الأجهزة: الميزات الرئيسية لـ NVIDIA GPUs مثل H100

Tensor Cores هي قلب الرقاقة. تتعامل مع العمليات الرياضية الدقيقة مثل FP8 و FP16. الذاكرة عالية السرعة HBM تساعد في نقل البيانات بسرعة. NVLink تربط الرقائق معاً لنماذج كبيرة. على سبيل المثال، H100 يقدم 4 بيتافلوبس في FP8. هذا يجعلها مثالية لتدريب نماذج اللغة الكبيرة.

الدقة العالية: تدعم FP8 لتوفير الطاقة دون فقدان الجودة.

الذاكرة الواسعة: 80 جيجابايت HBM3 في H100.

الربط السريع: NVLink يصل إلى 900 جيجابايت/ثانية بين الرقائق.

النظام البيئي القوي: CUDA والاعتماد على البرمجيات

CUDA تجعل البرمجة سهلة للمطورين. مكتبات مثل cuDNN تدعم التعلم العميق. الشركات تعتمد عليها لأنها ناضجة. OpenAI و Meta يستخدمان NVIDIA لنماذجهم الكبيرة. هذا الاعتماد يبني حاجزاً عالياً أمام المنافسين.

معايير الأداء والاستخدام الواقعي

H100 يدرب نموذج GPT-3 في أيام قليلة. يصل إلى 2 بيتافلوبس في FP16. شركات مثل Microsoft تعتمد عليها بالكامل. في الاستدلال، تكون سريعة للمهام اليومية. هذا يجعلها خياراً أولاً للعديد.

السيليكون المخصص لغوغل: استراتيجية وحدة معالجة التنسور TPU

غوغل أنشأت TPUs لتحسين TensorFlow. بدأت في 2016 للسيطرة على سلسلة التوريد. الإصدارات الجديدة مثل TPU v5e و v5p تركز على الكفاءة. هذه الرقائق مصممة للعمل داخل غوغل كلاود.

التخصص المعماري: محركات ضرب المصفوفات

TPU تستخدم تصميم systolic array. هذا مثالي لضرب المصفوفات في نماذج Transformer. تركز على السرعة العالية بدلاً من المرونة. على سبيل المثال، TPU v4 يقدم 275 تيرافلوبس في BF16. هذا يناسب تدريب النماذج الكبيرة مثل PaLM.

التصميم الخاص: يقلل من حركة البيانات داخل الرقاقة.

الكفاءة في الطاقة: أقل استهلاكاً للكهرباء مقارنة بـ GPUs.

التوسع: تدعم آلاف الرقائق في كلاود غوغل.

التكامل والوصول: منصة غوغل كلاود و JAX

TPUs متاحة عبر GCP فقط. تحتاج إلى JAX أو TensorFlow المحسّن. هذا يجعلها سهلة لمستخدمي غوغل. لكن تغيير الكود يأخذ وقتاً.

التوازن بين التكلفة والمرونة

TPUs أرخص للمهام الثابتة. في تدريب نموذج كبير، توفر 30% من التكلفة. لكن للمهام المتنوعة، GPUs أفضل. إذا كنت في غوغل كلاود، جربها أولاً.

دخول أمازون: AWS Trainium و Inferentia للتحسين السحابي

أمازون تريد تقليل الاعتماد على NVIDIA. Trainium مصمم للتدريب داخل AWS. Inferentia للاستدلال. هذا يجعل AWS أكثر استقلالية.

عمارة Trainium: مصممة للبنية التحتية في AWS

Trainium تندمج مع EFA للشبكات. ترتبط بـ S3 للتخزين. هذا يسرّع الوصول إلى البيانات. الرقاقة تدعم PyTorch عبر Neuron SDK. تركز على الكفاءة في السحابة.

الربط الداخلي: يدعم 100 جيجابت/ثانية مع الخدمات الأخرى.

التصميم البسيط: أقل تعقيداً للمستخدمين في AWS.

القوة: 800 تيرافلوبس في FP16 لـ Trainium2.

حالات الاستخدام: المهام الأصلية في AWS والسيطرة على التكلفة

للشركات في AWS، Trainium مثالي لضبط النماذج. يوفر 50% من التكلفة في التدريب الكبير. Anthropic يستخدمها لنماذجها.

عقبة البرمجيات: ربط PyTorch مع Neuron SDK

تحويل الكود من PyTorch إلى Neuron يحتاج جهداً. ليس سهلاً مثل CUDA. لكن AWS تقدم أدوات للمساعدة. إذا كنت ملتزماً بـ AWS، استثمر في التعلم.

التحليل المقارن: الأداء والتكلفة الإجمالية وملاءمة المهام

الآن نجمع المعلومات. NVIDIA قوية في المرونة. TPUs سريعة في المهام الخاصة. Trainium توفر في AWS.

معايير الأداء عبر أنواع المهام

في تدريب LLM قياسي، H100 أسرع بنسبة 20% من TPU v4. Trainium يقارب في AWS. GPUs تفوز في المهام الصغيرة. TPUs للنماذج الكثيفة.

التدريب الكبير: TPUs أفضل في السرعة لكل دولار.

المهام المتنوعة: NVIDIA تتفوق هنا.

الاستدلال: Inferentia رخيصة جداً.

الغوص في التكلفة الإجمالية

TCO تشمل السعر والطاقة والمهندسين. NVIDIA غالية لكن سهلة. TPUs توفر 40% في GCP. Trainium أقل في AWS بسبب التكامل. عامل الطاقة: TPUs أكثر كفاءة.

نصيحة عملية: اختيار الرقاقة المناسبة لفريقك

إذا أردت مرونة، اختر NVIDIA. للسرعة في GCP، اذهب إلى TPUs. في AWS، جرب Trainium. فكر في خبرتك وميزانيتك.

المشهد المستقبلي: الاتجاهات الناشئة والتحديات التنافسية

المنافسة ستزداد. Blackwell من NVIDIA قادمة في 2024. TPUs v6 ستكون أقوى.

صعود الوصلات المتخصصة والرقائق الصغيرة

Chiplets ستجعل الرقائق أكبر وأرخص. الوصلات مثل NVLink ستتحسن. هذا يساعد في التوسع.

مبادرات الأجهزة مفتوحة المصدر والبدائل

RISC-V ينمو كبديل. شركات ناشئة مثل Groq تقدم رقائق سريعة. لكنها ليست جاهزة بعد للسوق الكبير.

الخاتمة: اتخاذ قرارات الأجهزة للهيمنة في الذكاء الاصطناعي

NVIDIA توفر نظاماً ناضجاً. TPUs تعطي كثافة متخصصة. Trainium يعد بتوفير من التكامل. الخيار يعتمد على احتياجاتك. هل أنت في سحابة معينة؟ ما حجم نموذجك؟ ابدأ بتقييم فريقك. جرب المنصات المجانية أولاً. هذا يضمن نجاح مشروعك في عالم الذكاء الاصطناعي السريع.

المصدر: CNBC